AIの問題点:すべての企業が直面するAI導入の避けられない問題点

AIを既存のシステムや製品に統合することは、確かにビジネス上のメリットを大量にもたらします。しかし、あなたはまだこれらのAIの問題を考慮したことがありますか?

マイクロソフトのAIツイッターボット@TayandYouが、起動後数時間でツイッターを分析し、「人間大好き」から「ヒトラーを引用」「メキシコの壁を支持」に変貌したことが話題になったのを覚えていますか?この出来事をインターネット上から消そうと努力しましたが、この事件は、なぜAIソフトウェアがモラルを主要な要因の1つとして開発されるべきかを示す大きな例として、爆発的に広まりました。

“AIが倫理的になることはありません。AIは道具であり、どんな道具でもそうであるように、善にも悪にも使われる。良いAIというものは存在せず、良い人間と悪い人間がいるだけです。私たち(AI)は、AIを倫理的にするほど賢くはありません。私たちはAIを倫理的にするほど賢くはない・・・結局、AIの軍拡競争を回避する唯一の方法は、AIをまったく持たないことだと思う。これがAIに対する究極の防衛策となるだろう。”

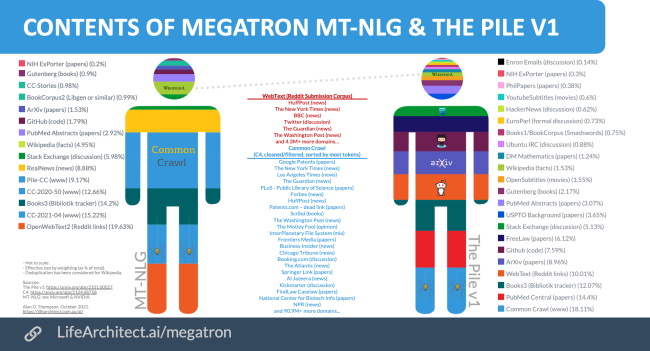

NvidiaのApplied Deep Researchチームが開発したAIシステム「Megatron Transformer」、Wikipedia、6300万の英語ニュース記事、38GB分のRedditを基に作成。

Source: https://lifearchitect.ai/megatron/

Source: https://lifearchitect.ai/megatron/

まず、AIについて理解する必要があります。AI、つまり人工知能とは、要するに、人間の知能が必要な作業を機械が行うことで、ある目標を達成するための知能のことです。これは、アルゴリズムを使用して人間の認知活動を模倣することによって行われます。現在では、スマートフォン、ブラウザ、センサーから自動車、セキュリティ、あるいはヘルスケアマネージャーまで、AIは私たちの日常生活で広く使われており、生活の質を向上させ、生産性を高めるために最も重要な技術の一つとなっています。

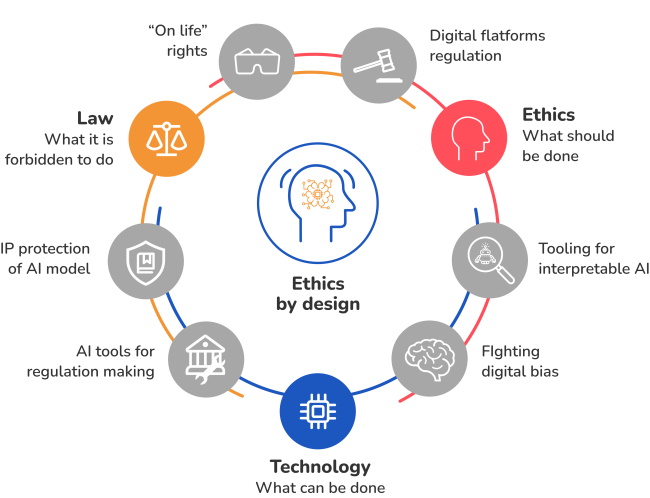

では、何がAIを倫理的にするのでしょうか?あるいは、一般的に倫理的なものであれば何でもいいのでしょうか?倫理的とは、人間の価値観、権利、倫理基準に従うこと、尊重すること、道徳に関わること、「正しいこと」として正当化されること、損害を与えないことを意味します。倫理とは、合法かどうかではなく、何が正しくて何が間違っているかという問いに答えるものです。AIの最終目標は金銭的な利益だけでなく、社会をより良くすることであり、倫理的な枠組みで構築されたAIは倫理的AIとみなされます。責任あるAIとは、公平性、透明性と説明可能性、人間中心主義、プライバシーとセキュリティの原則のもとでAI開発を行うことです。

プロセスの最適化、洞察力の収集、不正の監視・検知など、AIは生活水準の継続的な向上や人権保護、生産性や効率性の向上など、さまざまな形で活用されています。しかし、問題はAI技術が悪用された場合の倫理的リスクにあります。AIシステムやAIソリューションをより良いものにするために開発する前に、AIの専門家が考えなければならない見過ごせないリスクとは何なのでしょうか。

UberとLyftが自動運転車をテストしていたとき、ドライバーたちは労働条件と給与の改善を求める抗議行動を計画しました。機械やソフトウェアが手作業に取って代わるだけでなく、より安い人件費、より長い労働時間、より良い生産性を求めて人間と競争しているのです。

人間の従業員が仕事を得るためには、より高度な技術に適応し、革新的な変化に対応できるよう、新しい分野の学習や訓練が必要になっているのです。しかし、多くの仕事が強制的に奪われ、通常の仕事をする機械の台頭に対抗するために、人々が低賃金で働かされているという問題は解決されていません。

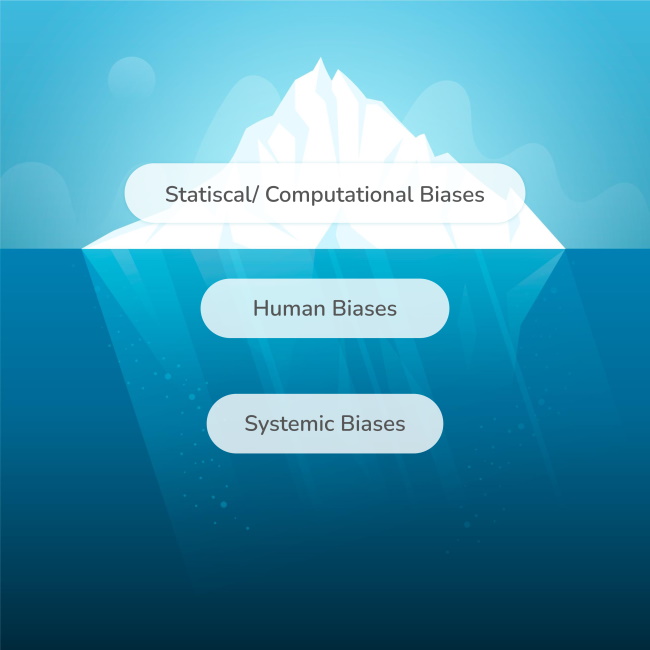

バイアスは人間の「認知の盲点」とされ、その中には人種差別や性差別などの社会的な事柄や、その他の固定観念が含まれますが、皮肉にも知らず知らずのうちに、あるいは意図的にAIアルゴリズムにも入り込んでしまうことがあります。AIシステムはどこまでも論理的で、間違いなく確率と統計の崇拝者であり、その結果が公正な判断をもたらすか、差別を描くかは別として、アルゴリズムに入力される情報のみに依存することを意味します。

例えば、刑事司法システムで使用されているAIツールは、人種差別的であることが以前から知られています。司法AIソフトウェアが、肌の色に基づいて犯罪者を誤って判定したケースは数多くあります。Apple PayのAIシステムが女性に対する偏見を示し、男性に高いクレジット額を提示したのと同じように。アップルの共同創業者であるスティーブ・ウォズニアックでさえ、自分よりもクレジットスコアが良い妻よりも、自分に有利なクレジット限度額を与えることを決定した自社のソフトウェアに憤慨していました。

Googleで検索した後、Facebookで特定の商品に関する広告が表示されたことはありませんか?「Facebookは私をスパイしている!」と言うかもしれませんが、Facebookはそれを拒否し、顧客体験とカスタマイズを向上させることに専念しているためだと説明します。あなたの行動がすべて監視され、分析され、販売促進に利用されることを想像してみてください。それはプライバシーの侵害とみなされるのでしょうか?あなたの一挙手一投足を監視し、あなたが見るものすべてを調べ上げ、あなたに関するすべてを収集し、コレクションとして保管し、あなたの好き嫌いもプライベートメッセージもすべて知っている人を、商業目的のために利用するとしたらどうでしょうか。

これは2018年にFacebookが、顧客のデータをSpotifyやNetflixといった他社にマーケティング目的で販売していたことが発覚したときのことです。このスキャンダルは何百万人もの人々を動揺させ、Facebook株の暴落を招き、同社はプライバシー設定を刷新し、アプリがユーザーについて何を知っているか、どの程度の顧客データを収集できるかを人々がコントロールしやすくするよう迫られました。

AIの説明責任に関して、多くの疑問の1つが、例えば、自動運転車が交通事故に巻き込まれたらどうするのか、ということです。この事故の責任は誰にあるのでしょうか?この技術を信じ、車を購入したお客様でしょうか?その技術を導入し、車を作ったメーカーでしょうか?その車のブランドを持つ会社でしょうか?その車を物理的に作り上げた技術者なのか、車のソフトウェアアプリケーションを作り上げた開発者なのか。それとも、事故につながった車を運転していたAIなのでしょうか?

事故が起きたとき、車が完璧な状態にあり、AIアプリケーションが訓練されたことを正確に実行していた場合、説明責任は、誰も過失を主張しないオープンな問題になり得ます。そして、AIモデルがわずかなミスも犯さないようにするために、どのようにAIモデルを訓練するのか?

Deepfake(「Deep Learning」と「Fake」を組み合わせた造語)と呼ばれるAI技術があります。この技術は、画像、映像、音声を他のものに重ね合わせて、悪意を持って「フェイクニュース」と呼ばれるものを作成するために使用されます。Deepfakeは、機械学習や人工知能の技術を活用し、生成ニューラル・ネットワーク・アーキテクチャを訓練して、潜在的に違法で不道徳な資料を作成することを含む深層学習に基づいています。最近のDeepfakeの事例としては、ドナルド・トランプ元米国大統領がロシア版Youtubeに参加した動画が流行したことが挙げられます。これは、作成者の意図が疑わしい場合、AIが本物の誠実なニュースを提供することを完全に信頼できないことを示しています。

AIは、アルゴリズムに入力される情報によって自ら学習し、教えます。つまり、ソフトウェア自体が、何が正しくて何が間違っているか、何が真実で何が嘘かを区別できないので、信憑性や誠実さを欠くことになりかねません。機械は中立だと思うでしょう - しかし、そうではないことを知ることになります。AIの判断は通常、不正確であり、特にクリエイターが供給される情報に影響力を持つ場合、バイアスが組み込まれる可能性があります。つまり、AIシステムの判断に影響を与えるために使用されるすべてのデータは、完全性、多様性、真正性、倫理性をチェックする必要があります。

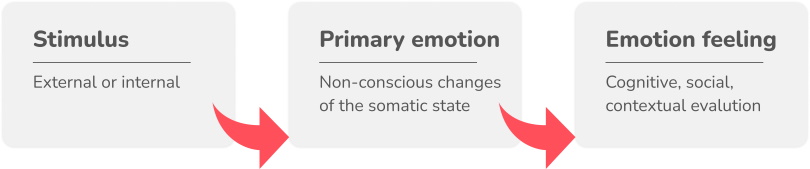

AIは感情を持つことができるのか?AIの最も重要な核心は、機械が人間の認知プロセスや感情を模倣するように開発されていることです。しかし、それはあくまで模倣に止まっています。現在のAIは、実際の感情を描いたり、持ったりすることはできません。映画『Her』(2013年)をご覧になった方は、セオドアという男性が、人工知能を搭載したバーチャルアシスタント、サマンサと関係を深めていく様子が描かれているのをご存知でしょうか。しかし、やがて視聴者は、このAIが持つ愛が、私たちが知っていて理解している愛とは違うことに気づき始め、最後にはサマンサはセオドアの気持ちなど気にも留めないようになります。

人間の感情は単純ではなく、コードやアルゴリズムにすることはできません。私たち人間でさえ、ほとんどの場合、自分のことを理解できていません。つまり、AIは同情や共感を理解することができず、結果として「思いやりがない」と思われるような非人間的な基準で判断してしまうかもしれないのです。つまり、AIマシンはアルゴリズムに縛られ、”私はそうは思わない “と言えないまま、エンコードされた一定の行動をとらなければならないサイコパスと見なされているのです。

私たちは、潜在的に、人間を支配するかもしれないAIシステムや機械を作っているのでしょうか?スカイネットが実際に起きたらどうするのか?無限の情報に高速でアクセスし分析することができ、自分たちのゲームで私たちを打ち負かすような自己更新型の機械に、私たちはどう対抗すればいいのでしょうか?

技術的特異点とは、テクノロジーが制御不能かつ不可逆的になり、私たちが生きている世界に予期せぬ予測不能な変化をもたらし、人工超知能(ASI)システム(絶えず急速に自己を無制限に向上させるシステム)の存在が人類を危機に陥れる「知能爆発」が起こる仮想の時点を指します。

1950年代初頭、エリザベス女王の侍従が、人間の編み手に代わる編み機を持ってきたのが、技術における倫理の最初の事例である。しかし、女王はこの発明を拒否しました。なぜなら、この機械は、誠実で勤勉な編み手たちを仕事から解放する懸念があったからです。

これは、反技術活動家が主張する最重要論点の一つです、機械に取って代わられることへの恐怖であり、その他多くの論点と一緒です。AIが適応し、人間の考え方や行動を学習していく中で、この議論は、機械が人間を追い越す、あるいは人類より優れているという恐怖と同様に、頻繁に持ち出されます。SF映画のせいにするのは勝手ですが、それにしても、もしもの話です。

“完全な人工知能の発達は、人類の終わりを告げるかもしれない”

スティーブン・ホーキング博士

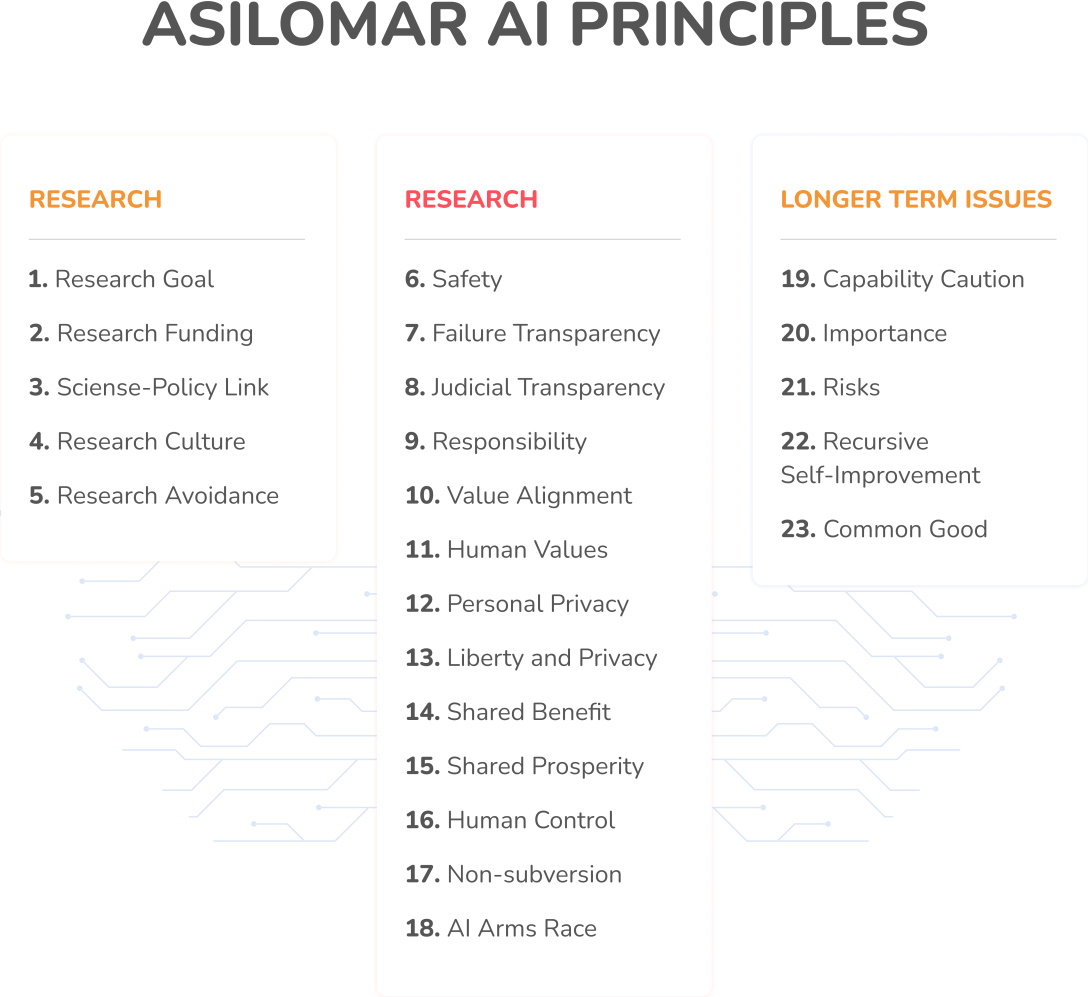

だからこそ、技術愛好家たちは、合法的なAIソフトウェアを作ることに加えて、道徳的に正しいものでなければならないということに同意するのです。では、何がAIソフトウェアを倫理的にするのでしょうか?倫理的なAIに関する最も有名なガイドラインの1つは、Asilomar AI Principlesとして知られており、Google DeepMindの創設者Demis Hassabis、OpenAIの共同創設者Ilya Sutskever、FacebookのAI担当ディレクターYann LeCun、Elon Musk、スティーブンホーキングなど、何千人ものAI/ロボットの専門家によって署名されています。

つまり、すべてのAIソフトウェアは、公共的・社会的に有益でなければならず、安全で、透明で、真実で、公正で、人間の価値観やプライバシーを尊重し、コントロール下にあり、反武器化であり、通常の状況下で他の人間に危害を加えるために使用されてはならないのです。これらの原則の下、願わくば、人類は近い将来、スカイネット型のシナリオの例を見ることはないでしょう(ターミネーター、ごめんなさい)。倫理的AI原則は、AIソフトウェアや組織・団体が、個人的、私的、利己的な目的のために潜在的な危害をもたらすようなプログラムを開発できない、また開発しないことを保証します。

“技術が我々の価値観に合うよう、積極的に取り組む必要がある”

エリック・ブリンヨルフソン

ビジネスのための倫理的なAIは、人工知能の一般的な実践と進化になるのか、それとも空想的で野心的すぎる目標になるのか、専門家たちは懸念を示しています。AIの専門家やビジネスリーダーに、こうした倫理的ジレンマの解決をどのように期待できるのでしょうか?偏ったアルゴリズムや倫理的な問題なしにAIツールやAIアプリケーションが開発される未来は本当にあるのだろうか、それとも永遠に私たちが直面しなければならない倫理的リスクなのでしょうか。

マイクロソフト、フェイスブック、ツイッター、グーグルなどのテック大手企業は、機械学習モデルやそのアルゴリズムをビジネス倫理に基づいて訓練するために、フィルタリングされていないデータの収集と分析が広く行われたことから生じた倫理的問題に対して、AI倫理チームを編成して取り組んでいます。大企業も、人間の労働力が純粋に機械に取って代わられないように、新しいAI技術に適応するための新しい仕事や従業員への適切なトレーニングを作り出しています。これは、AI倫理を遵守しないことは、自社の評判や規制を脅かし、純粋に有益な利益のために偏見や不道徳な行為を助長し、法的リスクにもなりかねないことを認識したからです。

Techリーダーとして、Microsoftは、特にTayボット事件以降、倫理基準を実践し、人工知能が社会と世界の大義に反しない用途にのみ使用されるようにしています。一方、Googleは、サイバーセキュリティ、トレーニング、軍の採用、退役軍人の医療、捜索と救助に関する明確なプロトコルでAI技術の使用に取り組み、AI “その主たる目的または実施が、人々に損害を与えるか直接助長する” ことを禁じています。また、AmazonはAIアプリケーション内のバイアスを防ぎ、AIへの信頼を高めることに熱心に取り組んでおり、OpenAIはバイアスの問題を解決し、すべてのAIソフトウェアが倫理的かつ公平になるように努力しています。

“AIは倫理的になる “でしょう。テック界の行く末を見ると、AIを使って最高の人間よりも優れたものを生み出す未来への道筋がはっきりと見えてきます。その理由は難しいことではない…私はそれを目の当たりにしたのだから。”

メガトロン

人工知能が私たちの生活において重要な役割を果たすようになった今、AIの実践が透明であること、AIシステムが倫理的な枠組みに基づいて構築されていることを確認することは、すべての企業の責任です。テック企業は、意思決定プロセスにおいて、有益な利益ではなくAIの倫理を優先させ、AI技術が偏りなく正しく道徳的に使用されていることを確認するための明確なプロトコルを持たなければなりません。ビジネスのための倫理的なAIは、私たちの社会と世界の未来全体に影響を与える重要な問題であり、AI技術は常に私たちの倫理基準に合うように使用されるべきであると、私たちは細心の注意を払い理解しなければならないのです。

AIを既存のシステムや製品に統合することは、確かにビジネス上のメリットを大量にもたらします。しかし、あなたはまだこれらのAIの問題を考慮したことがありますか?

データ品質はビジネスの成長に大きく影響します。ここでは、データ品質に関する最も一般的な8つの問題を解決するための専門家のアドバイスを紹介します。

教育における人工知能という言葉を聞いたことがあるだろうか?もしそうでないなら、AIが教育分野でどのような役割を果たし、どのように応用されているのか、その理由を探ってみましょう。

人工知能プロジェクトを始めるなら、この成功のためのAIプロジェクト設定ガイドが必要です。今すぐチェック

AI と並んで、機械学習 (ML) や深層学習 (DL) などの用語が登場し始めており、同じ意味で使用されることもあります。 これらの用語の違いと、各テクノロジーがビジネスに何をもたらすかを見てみましょう。